Avec l’avènement des grands modèles de langage (LLMs) et la multiplication des usages de l’IA, de nouveaux standards émergent pour faciliter l’accès à l’information sur les sites web. Parmi ces standards se trouve le fichier llms.txt, équivalent IA-first inspiré de robots.txt et sitemap.xml, mais spécialement conçu pour aider les LLMs (Large Language Models) et leurs outils (par exemple ChatGPT, Claude, Cursor, Windsurf, Replit Ghostwriter, etc.) à mieux comprendre et utiliser votre contenu.

Dans ce mega guide en français, vous découvrirez :

- Les origines du

llms.txt - Ses bénéfices pour le SEO et l’accessibilité de l’information

- Comment l’implémenter sur votre propre site

- Les bonnes pratiques et pièges à éviter

- Des exemples concrets

- Des ressources et outils existants pour vous faciliter la tâche

1. Qu’est-ce que le llms.txt et pourquoi l’utiliser ?

Le fichier llms.txt est un fichier texte rédigé en Markdown (bien qu’il conserve l’extension .txt) que l’on place à la racine d’un site web, à l’instar de robots.txt. Il a pour vocation de guider directement les IA lors de la phase d’inférence (quand un utilisateur ou un agent conversationnel cherche des informations précises en temps réel), en fournissant :

- Une vue d’ensemble claire et simplifiée de votre site.

- Des indications structurées sur la façon dont le contenu doit être compris, extrait ou utilisé.

- D’éventuels liens vers des ressources critiques (documentation, pages d’API, FAQ, guides techniques, etc.) sous forme de Markdown.

- Des informations optionnelles pour enrichir le contexte (lorsque la fenêtre contextuelle d’un LLM est limitée en nombre de tokens, on peut définir un bloc de ressources secondaires pouvant être ignorées si nécessaire).

En d’autres termes, llms.txt devient un catalyseur qui oriente les IA vers le contenu essentiel et évite qu’elles n’analysent de façon approximative, ou trop volumineuse, les pages HTML classiques remplies d’éléments de design, d’animations et de publicités.

1.1 Contexte et besoin

- Les LLMs sont souvent limités par leur fenêtre de contexte et ne peuvent charger ou traiter l’intégralité d’un site volumineux.

- Les HTML peuvent être complexes à parser (barre de navigation, menus déroulants, script JS).

- Les IA n’ont pas nécessairement la même logique de “crawl” que les moteurs de recherche (GoogleBot, BingBot), et certains IDE ou agents conversationnels (Cursor, Claude Code, etc.) requièrent une version “texte brut” ou “Markdown” d’une documentation.

Ainsi, llms.txt rationalise la façon dont les IA obtiennent un aperçu du site, permettant un meilleur usage en phase d’inférence (ex. suggestion de code, réponses expertes, ChatGPT Plugins, etc.).

2. Quelle différence entre llms.txt, robots.txt et sitemap.xml ?

robots.txt: Indique aux robots (ex. GoogleBot, BingBot) les endroits où ils peuvent ou ne peuvent pas crawler. Il ne fournit pas de contenu, seulement des règles d’accès.sitemap.xml: Liste l’ensemble des pages indexables pour les moteurs de recherche (URL, date de mise à jour, priorités). C’est très utile pour le SEO, mais ça ne fournit pas de description du contenu ni ne mentionne la forme “IA-friendly” des pages.llms.txt: Fichier Markdown adressé aux IA pour décrire ou pointer vers des pages exploitées à l’inférence. Il peut également inclure des extraits stratégiques, des liens externes fondamentaux, et même des versions.mdde vos pages. C’est un outil volontaire, pensé pour rendre service directement aux agents IA. Il peut compléter, et non remplacer,robots.txtousitemap.xml.

3. Structure et format recommandés

Le fichier llms.txt se veut simple et flexible. Voici la structure proposée :

# Nom du site ou du projet

> Courte description ou résumé du site (blockquote)

Texte libre en paragraphes, conseils ou notes nécessaires

## Section principale

- [Titre du lien](URL_de_la_ressource) : Description éventuelle

## Section optionnelle

- [Titre du lien](URL_de_la_ressource)3.1 Points clés :

- H1 : Le titre principal, le nom du site ou du projet, unique et obligatoire.

- Blockquote : Brève description du site (quelques lignes).

- Corps du fichier : Paragraphe(s) supplémentaires pour clarifier le rôle du site, ou donner des directives sur la manière d’interpréter certains éléments de contenu.

- Sections délimitées par des H2 :

- Listez, via un format de liste en Markdown, des liens vers des ressources pertinentes.

- Mentionnez éventuellement des liens externes critiques (par ex., si votre doc est dispersée sur GitHub, GitLab, ou d’autres sites).

- Vous pouvez avoir plusieurs sections, comme “API”, “Tutoriels”, “Exemples”, etc.

- Section “Optional” : Permet d’indiquer aux IA que cette section est moins prioritaire. Si l’IA manque de place, elle peut ignorer ces contenus.

Note : Les URL peuvent finir par .md si vous voulez proposer directement la version texte/Markdown de vos pages.

4. Exemples concrets

4.1 FastHTML

Dans la documentation de FastHTML, on trouve un llms.txt (fichier de démonstration) qui pointe vers :

- Un quick start

- Une référence HTMX

- Des exemples avancés

- Des ressources optionnelles sur Starlette

4.2 Anthropic, Perplexity, ElevenLabs, Cloudflare

- Anthropic : propose un

llms-full.txtavec la totalité de leur documentation. Cela facilite l’usage dans des IDE ou des chatbots (par ex. Cursor) qui chargent directement ce fichier. - Cloudflare : envisage la mise à disposition d’un

llms.txtdédié pour décrire ses services. - LangChain, LangGraph : fournissent déjà

llms.txtetllms-full.txtpour permettre de charger la doc dans un agent conversationnel.

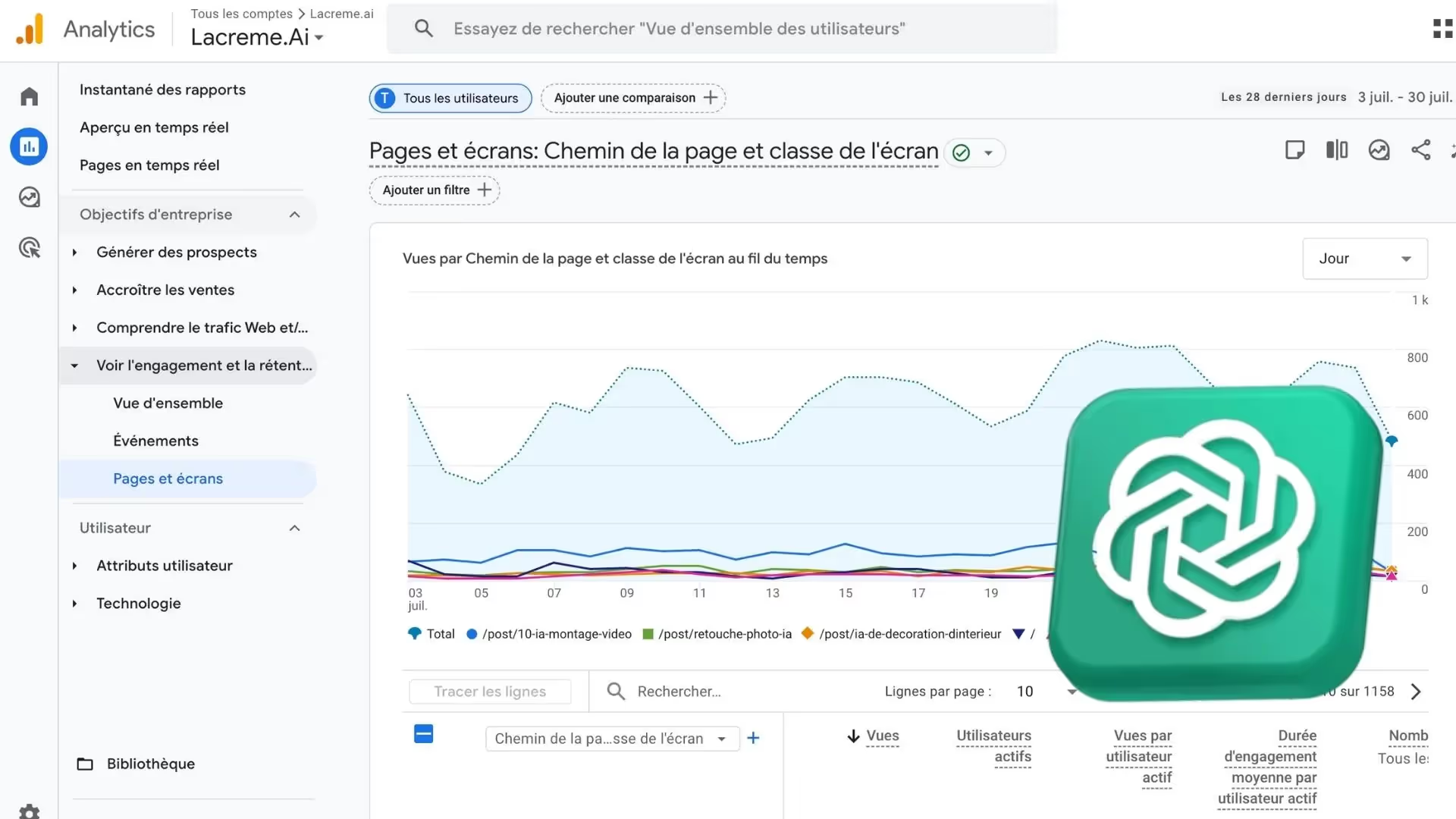

5. Avantages pour votre référencement (SEO) et votre stratégie de contenu

Même si llms.txt ne s’adresse pas directement aux moteurs de recherche classiques, il améliore indirectement le SEO :

- Meilleure visibilité dans les environnements IA. Lorsque quelqu’un interroge un ChatGPT-like ou un outil IA connecté, votre contenu a plus de chances d’être correctement identifié et cité.

- Réduction du bruit : Vous fournissez le contexte essentiel, ce qui peut diminuer la confusion ou la désinformation.

- Amélioration de l’expérience utilisateur : Dans des IDE et assistants code, les suggestions sur votre librairie/outil seront plus justes, augmentant la satisfaction des utilisateurs et favorisant bouche-à-oreille positif.

- Autorité de marque : Montrez que votre site est “AI-Ready” et exploite les standards modernes (un argument marketing et confiance).

6. Comment générer et maintenir votre llms.txt ?

6.1 Méthode manuelle

- Lister vos pages prioritaires (guide d’installation, doc API, FAQ produit).

- Ajouter un résumé concis par lien (

: brève présentation). - Structurer avec des titres

##, sections “facultatives”, etc.

6.2 Outils et plugins

Plusieurs projets open source et services SaaS proposent de générer votre llms.txt automatiquement :

- llmstxt Generator par Firecrawl ou dotenvx : Parcourt votre sitemap, extrait les infos clés et crée un squelette de

llms.txt. - Plugins WordPress (ex. “Website LLMs.txt”) : scanne vos articles/pages et génère un fichier structuré.

- Services comme Mintlify, LangGraph, ou llmstxthub.com qui analysent vos docs et en sortent un

llms.txt. - VSCode Extensions (

LLMs.txt Explorer) : pour charger ou créerllms.txtdepuis l’éditeur.

6.3 Bonnes pratiques de mise à jour

- Mettre à jour après chaque changement majeur de votre doc ou ajout d’une nouvelle section importante.

- Vérifier régulièrement les liens externes, car un lien brisé dans

llms.txtpeut induire les IA en erreur. - Conserver un format minimaliste (inutile d’y intégrer toute la doc, juste de quoi guider l’IA vers les ressources plus détaillées).

7. Les controverses et limitations

- Manipulation du contenu : Certains craignent que des acteurs mal intentionnés insèrent des informations trompeuses dans

llms.txt. Les LLMs, s’ils se fient aveuglément au fichier, peuvent “halluciner” ou propager de fausses infos. - Adoption : Pour que la norme fonctionne, il faut que les IDE/agents la respectent. Certains projets IA l’ignorent, d’autres la soutiennent déjà.

- Format non standard officiel W3C : Certains experts prônent la mise en place d’un chemin

/.well-known/llms.txtpour s’aligner sur RFC 8615, tandis que d’autres préfèrent rester sur un usage direct commeexample.com/llms.txt.

8. Conclusion : Faut-il adopter le llms.txt pour booster votre SEO IA ?

Le llms.txt n’est pas une obligation, mais il gagne en popularité auprès des IDE intelligents, plugins IA et communautés open source. Il simplifie la tâche d’intégration de contenu dans des projets d’IA en temps réel, évite le gaspillage de tokens, et favorise une documentation mieux comprise par les modèles de langage.

Ressources complémentaires

- Dépôt GitHub : github.com/AnswerDotAI/llms-txt

- Article détaillé : Search Engine Land — LLMs.txt standard

- Outils de génération :

En résumé

Le fichier llms.txt se présente comme une nouvelle pièce maîtresse dans la panoplie d’outils SEO et IA. En fournissant un condensé hiérarchisé de vos contenus importants, il facilite la recherche contextuelle par les agents conversationnels et valorise votre documentation technique. À l’heure où les chatbots et IDE intelligents deviennent la “nouvelle porte d’entrée” vers l’information, adopter llms.txt peut faire la différence.

N’attendez pas pour l’implémenter ! Profitez dès aujourd’hui de la synergie entre votre SEO traditionnel et cette nouvelle strate IA, afin d’offrir la meilleure expérience possible aux utilisateurs… humains et intelligences artificielles.